La inteligencia artificial (IA) se considera una de las tecnologías más prometedoras para cambiar la forma en que las personas se relacionan con su entorno. No obstante, su uso también se ha extendido entre los delincuentes. Las compañías de ciberseguridad y las entidades del sector tecnológico han alertado sobre el incremento alarmante de aplicaciones ilegales de las herramientas de deepfake, es decir, aquellas que utilizan IA para alterar imágenes o grabaciones de individuos y generar contenidos audiovisuales falsos.

Es tanto así, que datos de la ONG Cyberpeace Institute revelan que la pornografía que aplica esta tecnología “se duplica cada seis meses en las plataformas de streaming más populares”. Entre 2022 y 2023, se observó un aumento de diez veces en los casos de fraude en diversas industrias. Además, estas técnicas están siendo aplicadas para perpetrar otros delitos, como la suplantación de identidad y el fraude en documentos.

La CEO de la ONG Cyberpeace Institute especializada en ciberamenazas y financiada por empresas como Microsoft y Mastercard ,Stéphane Duguin, reveló en una entrevista realizada por El País que “lo que conocemos como deepfake comenzó como un proyecto de código abierto para crear contenido sexual ilegal. Por lo tanto, no es de sorprender que un asombroso 96% de estos videos estén relacionados con pornografía no consentida. Este mal uso incluye pornovenganza, extorsión, humillación e incluso explotación infantil en línea. Los rostros de las víctimas se superponen al contenido explícito sin su consentimiento, convirtiendo a los deepfakes en una herramienta devastadora para ataques personales y explotación”.

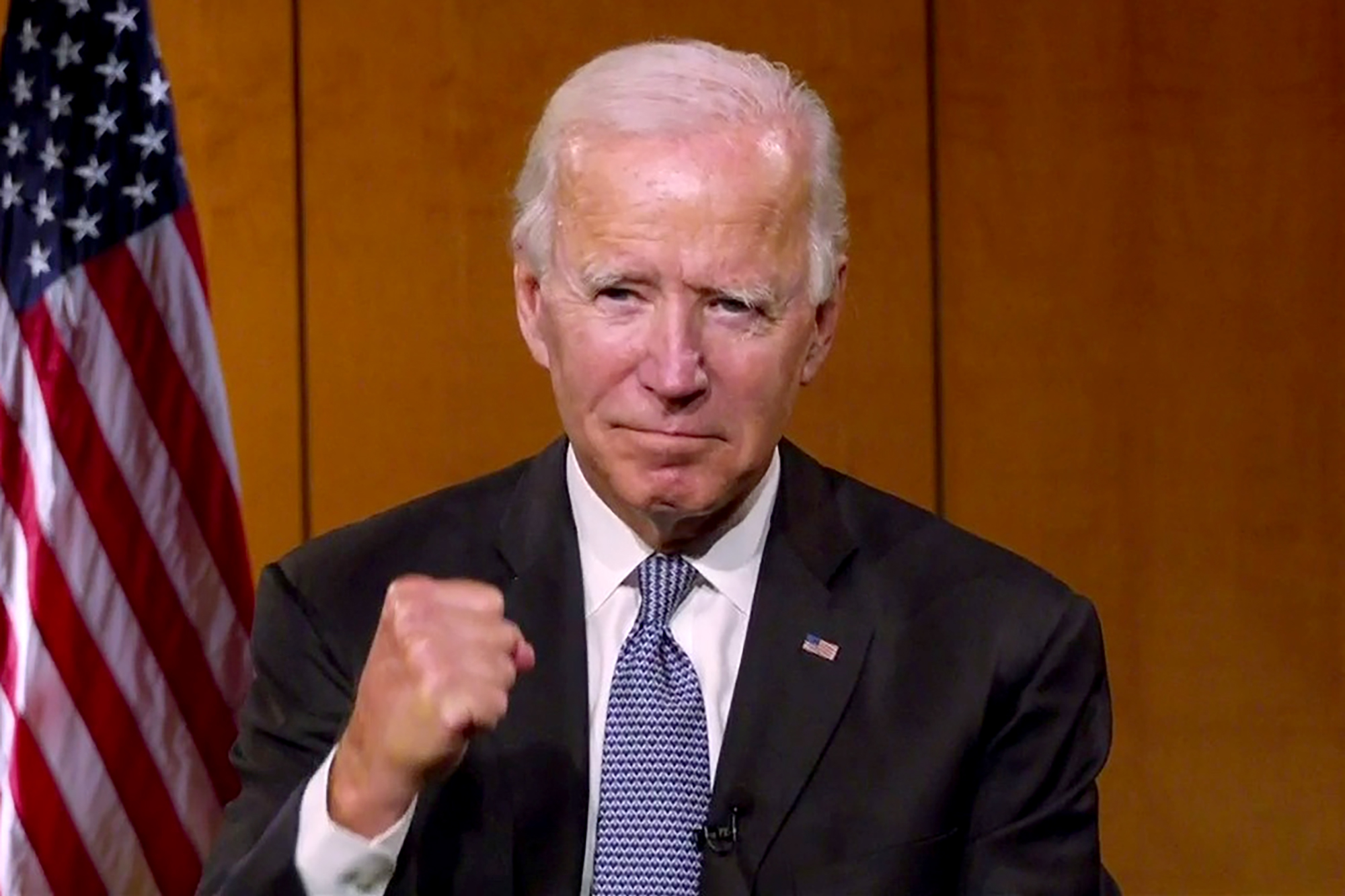

Un informe reciente de Unit 42, la división de investigación de Palo Alto Networks, una firma de ciberseguridad, ha puesto de manifiesto la existencia de bandas organizadas que se dedican a la creación de campañas de deepfakes. Estos grupos emplean sin autorización la imagen de celebridades para promover esquemas de inversión fraudulentos o incluso suplantan a ejecutivos con el fin de obtener dinero de sus víctimas.

Un caso reciente que ilustra este problema es el de la plataforma engañosa Quantum AI, que utilizó la imagen de figuras como el magnate Elon Musk, la presidenta de Italia, Georgia Meloni, y el ex presidente mexicano, Andrés Manuel López Obrador, para crear vídeos falsos destinados a atraer a los usuarios. «En la mayoría de los casos, los atacantes parecen haber comenzado con un vídeo auténtico y luego añadieron su propio audio generado por inteligencia artificial. Finalmente, utilizaron tecnología de sincronización de labios para ajustar el movimiento de los labios del orador, asegurando que coincidiera con el audio generado por IA», afirman los autores del informe.

En esta modalidad de fraude, se pide a las víctimas que se inscriban proporcionando su nombre y número de teléfono, y se les informa que recibirán una llamada de un gerente de cuenta o un representante. Posteriormente, los delincuentes cibernéticos contactan a la víctima por teléfono, exigiendo un pago de aproximadamente 250 dólares (alrededor de 223 euros) para poder acceder a la plataforma. Luego, se solicita a la víctima que descargue una aplicación específica que le permitirá «invertir» una mayor cantidad de sus fondos. Dentro de dicha aplicación, se presenta un panel que muestra pequeñas ganancias.

Ante esto, a nivel global, los gobiernos están tomando medidas para regular esta tecnología, aunque en muchos lugares la normativa es aún reciente. Un caso representativo es la Ley de Inteligencia Artificial de la Unión Europea, que fue aprobada en 2023 y se considera la primera regulación relevante centrada en la inteligencia artificial, incluyendo disposiciones que abordan de manera específica los deepfakes. De acuerdo con el Cyberpeace Institute, «el propósito de esta legislación es establecer controles más severos sobre las tecnologías de IA, garantizando la transparencia y la rendición de cuentas en su aplicación, lo que abarca la identificación de contenido manipulado».

Sin embargo, los expertos consultados coinciden en que estas herramientas a menudo son utilizadas para reinventar antiguas formas de estafa que se aprovechan del factor humano, siendo las misma estafas hechas anteriormente, pero de una manera actualizada.

Por otro lado, se tiene que las principales razones que han impulsado el uso de esta herramienta por parte de los criminales se encuentra la aparición de distintas plataformas que ofrecen servicios de deepfakes, existiendo foros y canales en redes sociales donde los criminales venden o intercambian herramientas y/o servicios de creación de deepfakes valiéndose de la generación de contenido malicioso generado por IA (audios, vídeos, etc).

Según el Cyberpeace Institute, han emergido mercados especializados en los que tanto individuos como grupos pueden presentar solicitudes de contenido a medida, sentando así las bases para el crecimiento y proliferación de un nuevo nicho de mercado criminal que podría ir en ascenso gracias a la demanda existente.

Así pues, otras áreas como el fraude documental se ven en peligro de la misma forma. Cada vez más delincuentes emplean tecnologías de IA para generar documentación falsa como tarjetas de identidad, lo que les permitiría eludir el riesgo del reconocimiento facial.

En este sentido, otro de los temas que genera mayor preocupación entre los expertos es que estas herramientas están logrando afectar también la tecnología biométrica que se emplea para la verificación de identidad en sistemas de seguridad y aplicaciones. Duguin señala: “Una de las principales inquietudes es el reconocimiento facial. Esta tecnología, en particular el intercambio de rostros o su modificación, conlleva un riesgo significativo para estos sistemas, que dependen del análisis de los rasgos faciales para llevar a cabo la autenticación”.

En consecuencia, los deepfakes son capaces de producir videos dinámicos que resultan extremadamente realistas, logrando engañar a sistemas avanzados de reconocimiento facial y eludir los controles de verificación, como los que se encuentran en dispositivos telefónicos.